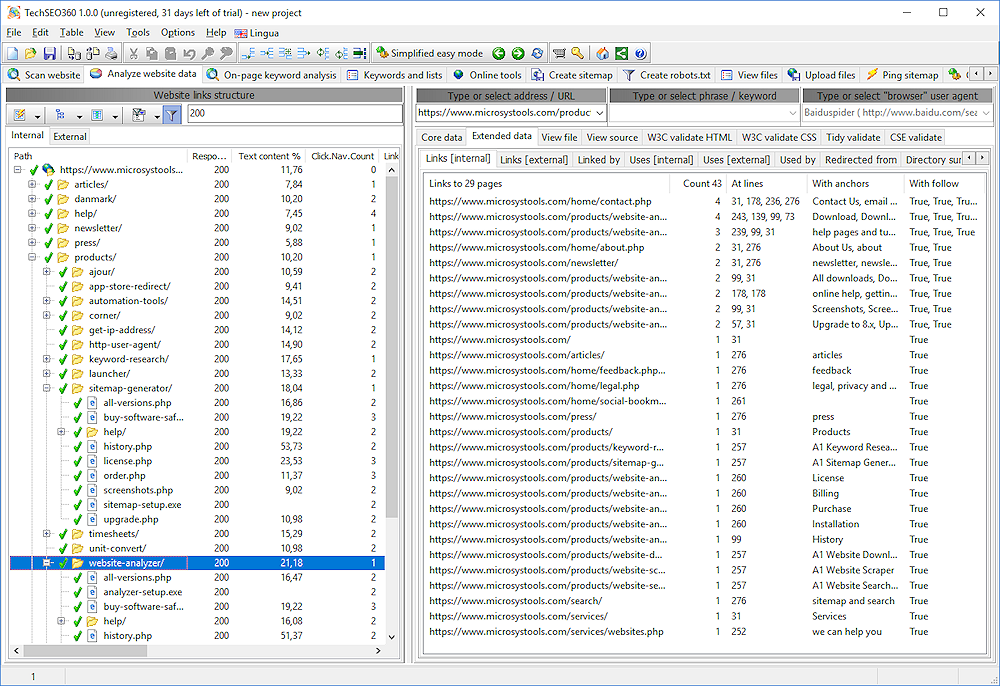

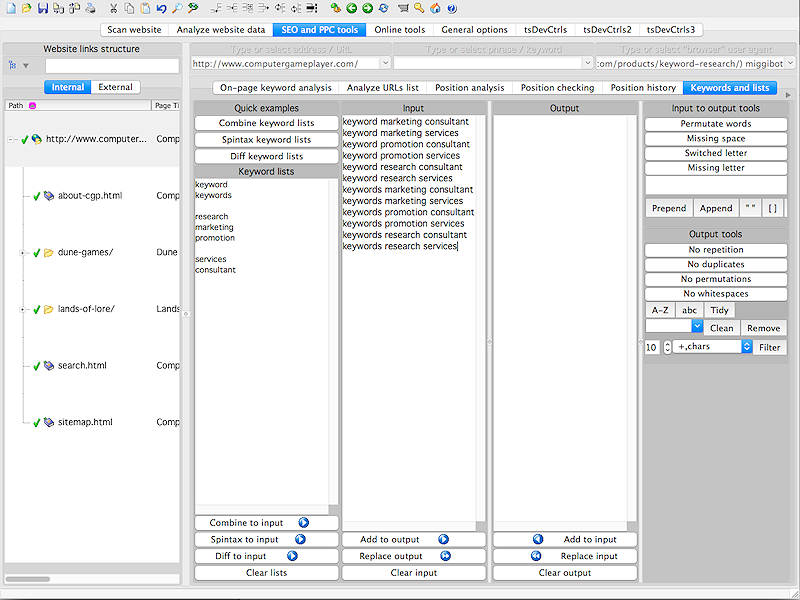

Полный инструмент искателя для аудит веб-сайтов, включая контент, внутреннюю связь и неработающие ссылки. Также можно создавать все типы файлов Sitemap, включая XML с hreflang, video, image, RSS / ROR, текст, пользовательский HTML / CSS / Javascript, DOT для графиков визуализации и многое другое. Никакой фиксированный верхний предел для количества URL-адресов на веб-сайте - практический предел зависит, но обычно он составляет 100 000 и 1000 000 страниц. Легко фильтровать результаты сканирования, просматривать и экспортировать выбранные данные в CSV и аналогичные инструменты. Механизм Crawler может быть настроен так, чтобы следовать пользовательским правилам, для которых страницы сканируются и какие URL-адреса должны включать в результаты. Поддерживает планирование через богатый интерфейс командной строки.

Что нового в этой версии:

Версия 1.0.5 может включать неопределенные обновления, улучшения или исправления ошибок.

Ограничения :

30-дневная пробная версия

Комментарии не найдены